كيفية إختبار والتحقق من ملف Robots txt المحظور من قبل Google أم لا

في عالم الإنترنت، حيث تتنافس المواقع على جذب انتباه المستخدمين، يصبح فهم كيفية عمل محركات البحث أمرًا بالغ الأهمية.

هل تساءلت يومًا عن كيفية تأثير ملف “robots.txt” على ظهور موقعك في نتائج البحث؟

هذا الملف الصغير يمكن أن يكون له تأثير كبير على كيفية زحف محركات البحث إلى صفحاتك. لكن ماذا لو كان هناك شيء غير صحيح في هذا الملف يمنع Google من الوصول إلى محتواك الثمين؟

هل أنت مستعد لاكتشاف الأسرار المخفية وراء ملف “robots.txt” وكيفية اختباره والتحقق مما إذا كان محظورًا من قبل Google؟ انضم إلينا في هذه الرحلة المثيرة لفهم كيفية تحسين وجودك الرقمي!

احصل على إجابات لأسئلتك واستعد لتغيير طريقة تفكيرك حول تحسين محركات البحث.

جدول المحتويات جدول المحتويات

- ما هو ملف robots.txt

- كيف يمكنني التحقق من أنني قمت بإعداد ملف robots txt الخاص بي بشكل صحيح؟

- اختبار ملف robots.txt:

- خطوات التحقق من ملف Robots.txt:

- خطوات اتباع الاختبار والتحقق من ملف Robots.txt المحظور من قِبل Google أم لا:

- تذكر أن دور محرك البحث هو أ) الزحف ، ب) الفهرس ، ج) تقديم النتائج.

ما هو ملف robots.txt

يعمل ملف Robots.txt على توفير بيانات قيمة لأنظمة البحث التي تقوم بمسح الويب. قبل فحص صفحات موقعك. تقوم روبوتات البحث بالتحقق من هذا الملف.

بسبب هذا الإجراء ، يمكن أن تعزز كفاءة المسح.

وبهذه الطريقة يمكنك المساعدة في البحث عن أنظمة لإجراء فهرسة لأهم البيانات على موقعك أولاً. ولكن هذا ممكن فقط إذا قمت بتكوين ملف robots.txt بشكل صحيح.

- ملاحظة : مهم! لكي يكون أمر noindex فعالاً ، يجب ألا يتم حظر الصفحة بواسطة ملف robots.txt.

إذا تم حظر الصفحة بواسطة ملف robots.txt ، فلن يرى الزاحف مطلقًا أمر noindex ، ولا يزال من الممكن أن تظهر الصفحة في نتائج البحث.

على سبيل المثال إذا كانت هناك صفحات أخرى مرتبطة بها. يمكنك الاطلاع على مزيد من التفاصيل حول ملف robots.txt حظر فهرسة البحث باستخدام علامة "noindex"

كيف يمكنني التحقق من إعداد ملف ROBOTS.TXT الخاص بي بشكل صحيح؟

يعد ملف Robots.txt ملفًا مهمًا جدًا لبرامج الزحف في محرك البحث ، فهو آلية لإبقاء صفحة الويب خارج google. وهي إلزامية للتحقق من ملف robots.txt واختبار ملف robots.txt.

ملف بعد التنفيذ على موقع الويب الخاص بك وإذا تم حظر أي عناوين URL عبر ملف robots.txt ، فيمكن الزحف إليها إذا كان يمكن العثور على عنوان url.

من الموارد الأخرى على الويب. ملف Robots.txt هو الملف الوحيد الذي يخبر برامج الزحف عن أي قسم من الملفات أو الصفحات يتم الزحف إليه .

ومدة تأخير الزحف إلى برامج زحف الويب ويستخدم أيضًا لتجنب التحميل الزائد على طلبات موقع الويب الخاص بك.

بمجرد الانتهاء من إنشاء ملف robots.txt لموقع الويب الخاص بك وتحديد أي قسم من صفحات الويب سيتم الزحف إليه بواسطة google.

فإن الخطوة التالية هي اختبار والتحقق من أن توجيهات ملف robots.txt تعمل تمامًا كما قمت بإنشائه أم لا. إذا سارت الأمور بشكل خاطئ.

فلن يقوم Google بالزحف إلى موقعك على الويب مما يؤدي إلى وقوع كوارث وعدم الحصول على موقعك في فهرسة بحث google في بعض الأحيان.

توفر Google أداة مفيدة لمالكي مواقع الويب ، كما أن Google Search Console تعمل على أفضل أداة تقدمها Google لاختبار ملف robots.txt.

من السهل جدًا اختبار ملفات الروبوت (تحقق من ملف robots.txt) عبر وحدة تحكم البحث والتحقق مما إذا كنت تحظر أي برنامج بوت من Google أم لا.

لدى Google العديد من برامج التتبع لمحركات البحث ، وتوفر وحدة تحكم بحث Google فحص جميع برامج الروبوت في كل مرة.

خطوات التحقق من ملف Robots.txt:

أداة اختبار robots.txt في وحدة تحكم البحث سواء كان ملف robots.txt الخاص بك يحظر زاحف الويب من قسم معين من موقعك على الويب أم لا.

إذا كانت هناك أي مشاكل أو أخطاء في ملف robots.txt ، فستخبرك Search Console بذلك. يمكنك أيضًا إدخال عناوين URL محددة للتأكد من فهرسة Google لها.

ما أدوات مدقق robots.txt يمكن أن تساعد

عند إنشاء ملف robots.txt ، تحتاج إلى التحقق مما إذا كانت تحتوي على أي أخطاء.

هناك بعض الأدوات التي يمكن أن تساعدك في التعامل مع هذه المهمة. Google Search Console الآن فقط الإصدار القديم.

من Google Search Console لديه أداة لاختبار ملف الروبوتات. سجل الدخول لحساب الموقع الحالي المؤكد على منصته واستخدم هذا المسار للعثور على مدقق.

الإصدار القديم من Google Search Console

> الزحف

> اختبار Robots.txt

كيفية التحقق من صحة ملف robots.txt الخاص بك

أول شيء بمجرد الحصول على ملف الروبوت الخاص بك هو التأكد من أنه مكتوب بشكل جيد والتحقق من الأخطاء.

يمكن لخطأ واحد هنا أن يسبب لك الكثير من الضرر ، لذلك بعد الانتهاء من ملف robots.txt .

عليك توخي مزيد من الحذر عند التحقق من وجود أي خطأ فيه ، حيث توفر معظم محركات البحث أدواتها الخاصة للتحقق من ملفات robots.txt.

و حتى تسمح لك برؤية كيفية رؤية برامج الزحف لموقعك على الويب, وكذالك كيفية استخدام أداة فحص عنوان URL في Search Console.

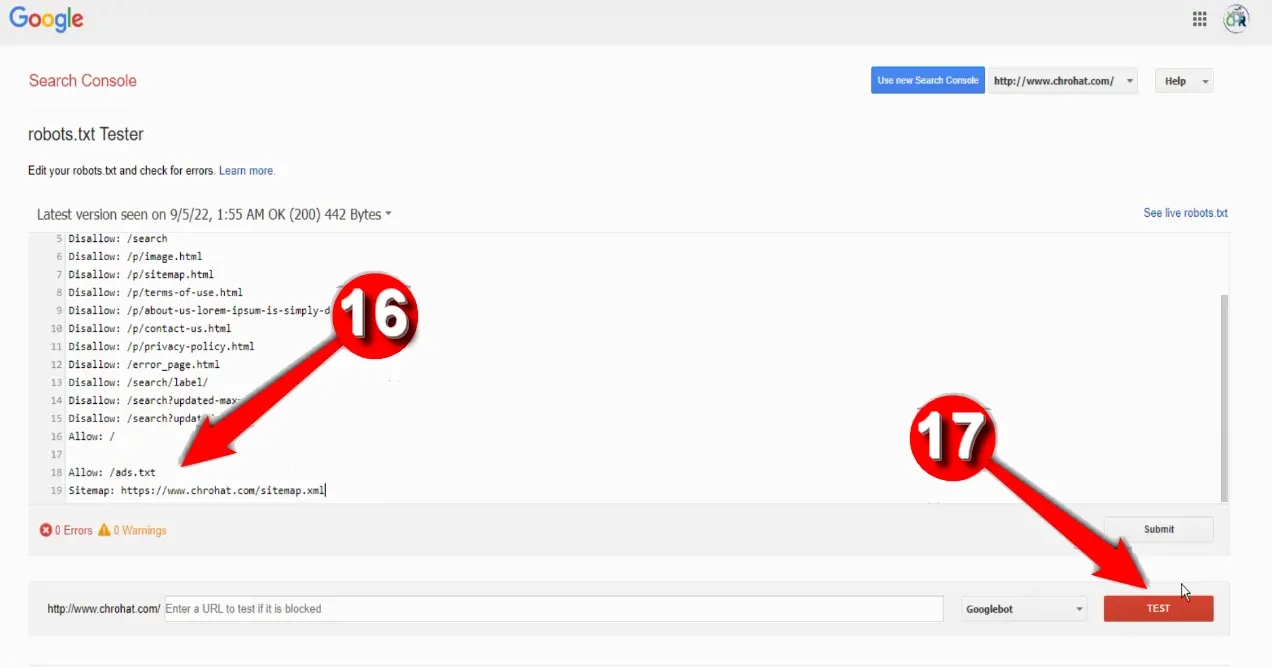

كما ترى في الصورة أدناه ، يمكنك استخدام اختبار الروبوتات GWT للتحقق من كل سطر ورؤية كل زاحف وما هو الوصول إليه على موقع الويب الخاص بك.

تعرض الأداة التاريخ والوقت لجلب Googlebot ملف الروبوتات من موقعك على الويب ، ورمز html الذي تمت مصادفته.

بالإضافة إلى المناطق وعناوين URL التي لم يتمكن من الوصول إليها.

يجب إصلاح أي أخطاء تم العثور عليها بواسطة المختبر نظرًا لأنها قد تؤدي إلى مشاكل في الفهرسة لموقعك على الويب ولا يمكن أن يظهر موقعك في SERPs.

1. قم بزيارة Google Search Console:

2. افتح الآن حساب وحدة تحكم بحث Google الخاص بك بنفس معرف البريد الإلكتروني المرتبط بـ Google Adsense

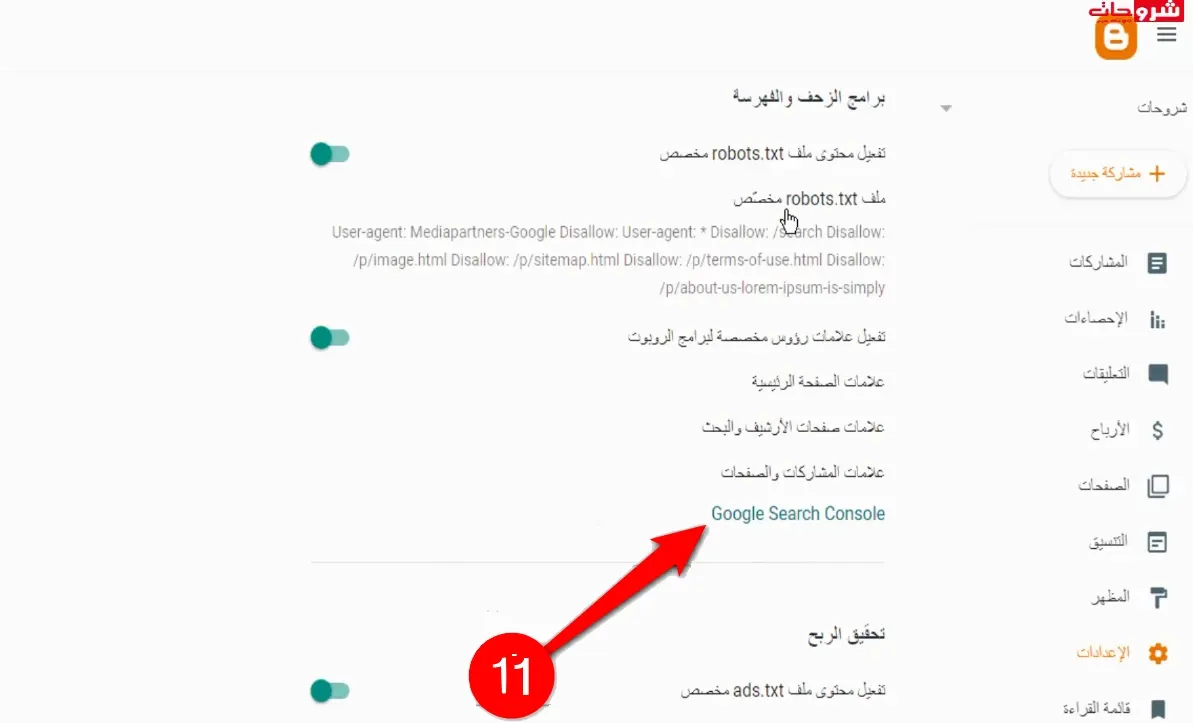

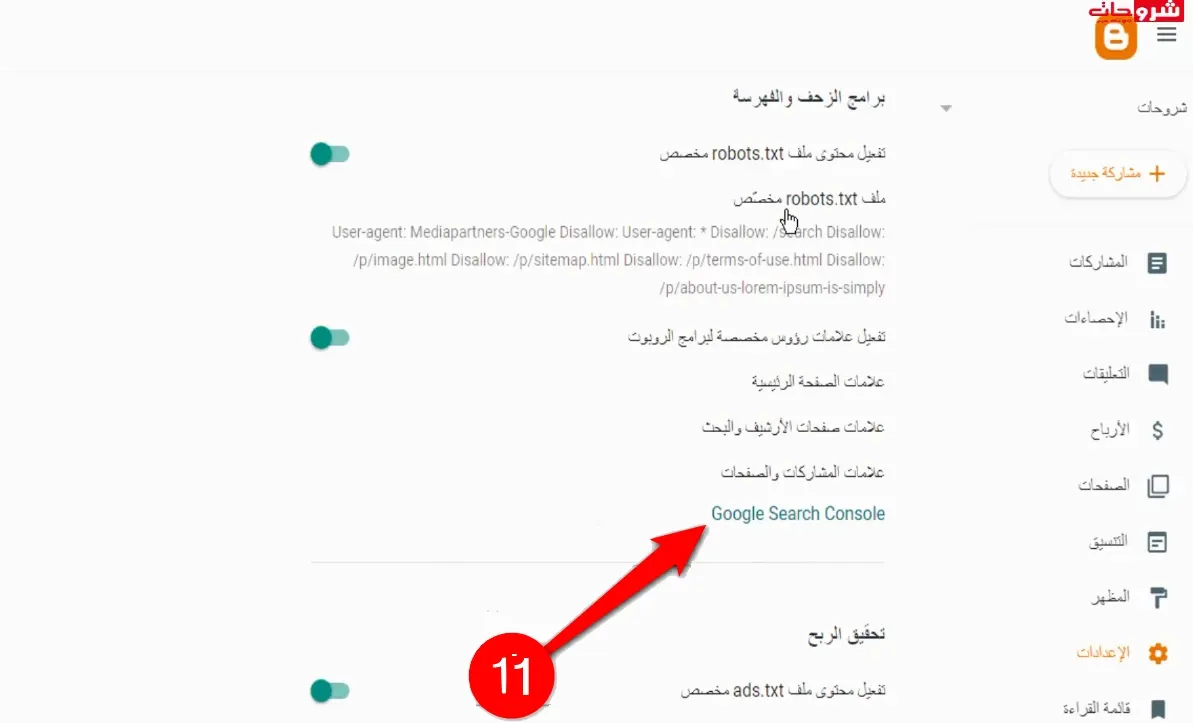

3. في محرك البحت في ليسار قم بكتابة robots.txt في محرك البحت بعد ذالك قم بإختيار الخيار الاول كما في الصور:

4. وانقر على رابط فحص عنوان URL:

5. بعد النقر على الرابط سوف يتم نقلك إلى صفحة نسخة القديمة من جوجل كونسول كما في الصورة.

6. قم بإختيار الدومين الخاص بك الذي تريد إضافة إليه الملف كما في الصورة:

7. نقوم بإضافة ملف من خلال كتابة Allow: /ads.txt كما يظر في الصورة:

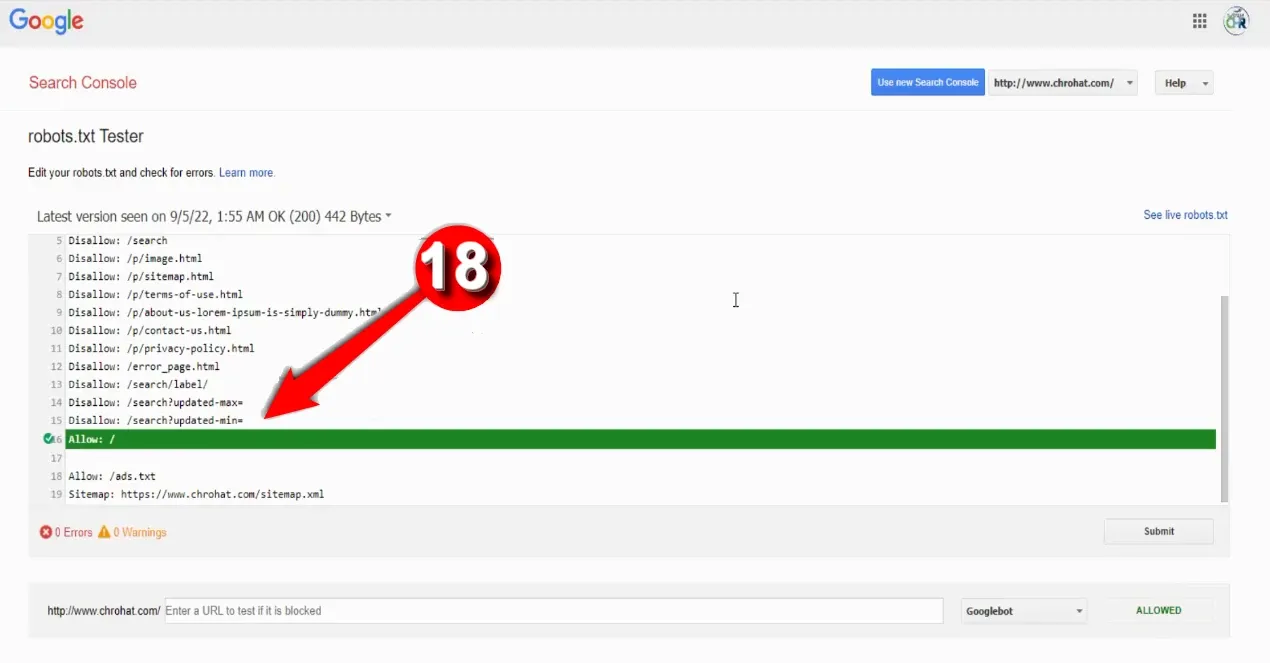

8. بعد إضافة الملف من خلال كتابة Allow: /ads.txt نقر كلمة TEST لبدئ عملية التحقق من ملف Sitemap:

9. انقر فوق اختبار عنوان Url المباشر متبوعًا بطلب الفهرسة.

10. الآن ستقوم Google Bots بالزحف إلى موقع الويب الخاص بك وسيتم فهرسته قريبًا.

11. بعد تحقق من الملف الان قم بالنقر على كلمة Submit:

12. ستكتشف Google تلقائيًا ما إذا كان الملف موجودًا على google أم لا ، إذا تلقيت رسالة Url ليست على google ، فحينئذٍ.

13. استخدم ملفًا يسمى "ads.txt" لسرد جميع الأماكن التي يجب أن تظهر فيها إعلانات AdSense الخاصة بك.

14. عند إضافة هذا الملف إلى موقعك ، ستقرأه Google وتتأكد من عرض إعلاناتك على المواقع التي قمت بإدراجها فقط:

15. بهذه الطريقة ، يمكنك التأكد من أن الأشخاص الذين يحاولون زيارة موقعك سيرون الإعلانات بالفعل ، وستجني المزيد من المال من AdSense.

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Allow: /

Sitemap: https://www.domin.com/sitemap.xml

يسمح لك اختبار robot.txt بما يلي:

- كشف جميع أخطائك والمشاكل المحتملة في وقت واحد ؛

- تحقق من الأخطاء وقم بإجراء التصحيحات اللازمة هنا لتثبيت الملف الجديد على موقعك دون أي عمليات تحقق إضافية ؛

- فحص ما إذا كنت قد أغلقت بشكل مناسب الصفحات التي ترغب في تجنب الزحف إليها وما إذا كانت الصفحات التي من المفترض أن تخضع للفهرسة مفتوحة بشكل مناسب.

يمكن أن يحظر ملف robots.txt الصفحات والأقسام التي يجب على محرك البحث الزحف إليها ولكن ليس بالضرورة فهرستها.

على سبيل المثال ، إذا قمت بإنشاء ارتباط وقمت بتوجيهه إلى صفحة ويب ، فيمكن لـ Google .

الزحف إلى هذا الرابط وفهرسة الصفحة التي يشير إليها الرابط. في أي وقت تقوم Google بفهرسة صفحة ، يمكن أن تظهر في نتيجة بحث.

إذا كنت لا تريد ظهور صفحة ويب في نتيجة بحث ، فقم بتضمين تلك المعلومات في الصفحة نفسها. قم بتضمين الرمز

<meta name = ”robots” content = ”noindex”>

في الصفحة المحددة لا تريد فهرسة محركات البحث.

من المؤكد أن ملف robots.txt هو جانب تقني أكثر من تحسين محركات البحث ، ويمكن أن يكون مربكًا.

على الرغم من أن هذا الملف يمكن أن يكون صعبًا ، إلا أن فهم كيفية عمل ملف robots.txt سيساعدك على التحقق من أن موقعك على الويب مرئي قدر الإمكان.

في الختام، يعد فهم كيفية اختبار والتحقق من ملف “robots.txt” خطوة حاسمة لضمان ظهور موقعك في نتائج البحث، مما يفتح أمامك آفاقًا جديدة لتحقيق النجاح الرقمي.

لا تتردد في استكشاف المزيد حول هذا الموضوع لتعزيز استراتيجيات تحسين محركات البحث الخاصة بك!

للمزيد من التوضيح كما عودناكم على مدونة دائما مرفوقة بالدرس فرجة ممتعة

وين رابط الصفحة وخفف الفاضي

ردحذفإرسال تعليق